استفاده مردم از هوش مصنوعی بهعنوان روانشناس و حذف شدن بخشهای مهمی از مغز

عضو انجمن روانشناسی ایران با تأکید بر اینکه هوش مصنوعی ساختهشده در کشورهای دیگری است و نمیتواند در روابط انسانی پاسخگوی نیازهای فرهنگی و خانوادگی همه کشورها از جمله ایران باشد، گفت: موضوعات بینفرهنگی در روانشناسی بسیار مهم است و بهطور مثال نمیتوان برای فردی که در تبریز زندگی میکند، همان راهکار را که برای فردی در تهران داده میشود، ارائه کرد.

هوش مصنوعی یا ChatGPT، ابزاری که بعضی افراد برایش اسمی دوستانه میگذارند و با آن درد دل میکنند، برخی مشکلات زناشویی یا روابط بینفردی خود را با آن در میان میگذارند و حتی عدهای روزشان را با «صبحبهخیر» گفتن به آن آغاز و شبشان را با «شببهخیر» گفتن به آن به پایان میرسانند اما پرسش اساسی این است، آیا این فناوری نوظهور میتواند واقعاً نقش یک دوست صمیمی یا حتی مشاوری آگاه و کارآمد را در حل مسائل روانی و بینفردی ایفا کند؟

حسین روزبهانی، عضو انجمن روانشناسی، در این رابطه در گفتوگو با «آوش» با بیان اینکه هر تکنولوژی نوظهوری در کنار مزایایی که دارد میتواند معایبی هم داشته باشد و هوش مصنوعی نیز از این قاعده مستثنی نیست، افزود: این مسئله که مردم از هوش مصنوعی بهعنوان روانشناس استفاده میکنند، میتواند بهصورت فردی و غیرفردی بررسی شود.

او ادامه داد: یکی از مشکلات فردی این است که این ابزارها معمولاً در پاسخ به سؤالات افراد، جوابهایی نظیر «خیلی سؤال خوبی مطرح کردید»، «خیلی عالی بود» یا «چقدر سؤال دقیقی بود» ارائه میدهند و این موجب میشود فرد تصور کند هوش و تواناییهای بالایی دارد و بهمرور انسانها را به افرادی خودشیفته تبدیل میکند، چون مدام در حال تأیید گرفتن است.

این روانشناس اظهار کرد: یکی دیگر از مشکلات فردی این است که وقتی بسیاری از سؤالات را از هوش مصنوعی میپرسیم، از برخی قسمتهای مغز خود استفاده نمیکنیم و در بسیاری زمینهها تحلیل، بررسی و تصمیمگیری انجام نمیدهیم. این مسئله موجب حذف شدن بخشهای مهمی از مغز میشود.

عضو انجمن روانشناسی ادامه داد: مشابه این اتفاق در استفاده از برنامههایی مثل بلد، نشان و ویز رخ داد و قسمت موقعیتسنجی و موقعیتیابی مغز ما حذف شد؛ تا حدی که در دوران جنگ دوازدهروزه که جیپیاسها قطع شد، افراد در پیدا کردن آدرسهای ساده نیز مشکل پیدا کردند بنابراین با حذف قسمتهای عالی مغز امکان تحلیل و حل مسئله از بین میرود که میتواند آسیبزا باشد.

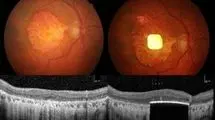

روزبهانی بااشاره به اینکه در زمینه بررسی مشکلات فردی مثل افسردگی و اضطراب و... در روانشناسی مواردی با عنوان «نشانه» و «علائم» داریم، گفت: نشانه چیزهایی است که روانشناس میبیند، مثل کبودی روی صورت یا غم چهره و... علائم، مسائلی است که دیده نمیشود. وقتی فرد به روانشناس مراجعه میکند، پزشک نشانه و علائم را با هم در نظر میگیرد. اما برای هوش مصنوعی بررسی نشانهها غیرممکن است و این میتواند موجب تشخیص اشتباه و آسیب شود.

این روانشناس افزود: استفاده از مشورت روانشناسی در زمینه روابط بینفردی نیز مشکلاتی را به دنبال دارد چراکه معمولاً در تراپیهای زوجین باید حتماً حرف دو طرف رابطه شنیده تا راهکار درست ارائه شود. زیرا هر فرد براساس دیدگاه شخصی خود مسائل رابطه را مطرح میکند و مشاوره یکطرفه نمیتواند راهکار درستی برای حل مشکل باشد. بنابراین استفاده از چتجیپیتی در این زمینه نیز قطعاً آسیبزا است.

او ادامه داد: حتی خود سازندگان هوش مصنوعیهایی نظیر ChatGPT اذعان میدارند که این برنامه هنوز دارای کاستیها و اشکالات ساختاری است و نیاز به اصلاح دارد بنابراین نمیتواند منبع مطمئن و کافی برای دریافت اطلاعات کامل و دقیق باشد.

روزبهانی با بیان اینکه در برخی موارد مشاهده شده که در جستوجوهای تکراری در موضوع مشخص و ثابت، ChatGPT پاسخهای متفاوت میدهد که نشاندهنده پاسخهای اشتباه است، گفت: در مواردی مثل رفتار انسان که بسیار پیچیده بوده و هنوز شبهپارادایم است و تبدیل به علم و پارادایم نشده و پیچیدگیهای خاص خود را دارد، این ابزارها نمیتوانند قابل اعتماد باشند.

او افزود: در بیماریها و مشکلات روانی در بیشتر موارد رویکردهای درمانی مختلفی وجود دارد و حتی در برخی اختلالات روانی چندین دسته دارویی مختلف تجویز میشود، درحالیکه در درمان بیماریهای جسمی داروهای ثابت و مشخصی وجود دارد و این، به دلیل پیچیده بودن روان انسان است. با وجود این پیچیدگیها حداقل در حال حاضر پلتفرم هوش مصنوعی ابزار مورد اعتمادی برای دریافت راهکارهای روانشناسی نیست.

این عضو هیات علمی دانشگاه اظهار کرد: آزمونهای روانی که در کشورهای دیگر ساخته شدهاند باید داخل کشور و بر اساس هنجاریابی و جامعه آماری کشور استانداردسازی شوند و با جامعه آماری مطابقت داشته باشند، در غیر این صورت روایی و پایایی این آزمونها تأیید نمیشود.

او ادامه داد: نمیتوان آزمونی را که مناسب جامعه آمریکا و آلمان ساخته شده، بدون استانداردسازی در کشور دیگر استفاده کرد چراکه مطابقت درستی با جامعه ندارند و امکان پاسخ اشتباه زیاد است. ضمن اینکه در موارد زیادی آزمونها به همراهی نظر متخصص نیاز دارند و کمکی هستند؛ یعنی ابتدا ارزیابی بالینی توسط تراپیست انجام میشود و آزمون به جمعبندی و اظهارنظر او کمک میکند، نه اینکه معیار باشد.

این روانشناس گفت: ممکن است افراد براساس نتیجه این آزمونها خود را مبتلا به یک اختلال روانی نظیر دوقطبی، پارانویا یا افسردگی بدانند و روحیه خود را از دست بدهند و عواقب بدی به سراغ آنها بیاید درحالیکه معمولاً روانشناسان و روانپزشکان بدون آگاه کردن فرد از نتیجه تست و بعد از ارزیابی دقیق همه دادهها و مشاهدات پزشکی نتیجهگیری قطعی انجام میدهند.

عضو انجمن روانشناسی ایران با تأکید بر اینکه هوش مصنوعی ساختهشده در کشورهای دیگری است و نمیتواند در روابط انسانی پاسخگوی نیازهای فرهنگی و خانوادگی همه کشورها از جمله ایران باشد، افزود: موضوعات بینفرهنگی در روانشناسی بسیار مهم است و بهطور مثال نمیتوان برای فردی که در تبریز زندگی میکند، همان راهکار را که برای فردی در تهران داده میشود، ارائه کرد.

وی ادامه داد: هر فردی در هر شهری با رعایت سنتها و آداب و فرهنگ مختلفی زندگی میکند. به طریق اولی این مسئله در مسائل روانشناسی بین کشورها و تفاوتهای فرهنگی در درمانهای روانشناسی پررنگتر نمود پیدا میکند.

روزبهانی اظهار کرد: رویکرد هوش مصنوعی در پاسخ به مشکلات افراد رویکرد تأییدی است و بیشتر نظرات افراد را تأیید میکند و این مسئله میتواند موجب بروز و ظهور رفتارهای خطرناک و اشتباه از سوی افرادی شود که تصمیمات اشتباه خود را با این پلتفرم در میان گذاشتهاند.

او در پایان تأکید کرد: هر تکنولوژی محاسن خاص خود را دارد و نمیتوان آن را حذف کرد اما باید از این ابزار بهعنوان عاملی در کنار اطلاعات، منابع و امکانات دیگر استفاده کرد. استفاده از مقالات روانشناسی، کتابها و نظرات تخصصی در کنار هوش مصنوعی لازم است و نباید هوش مصنوعی و ابزارهایی نظیر ChatGPT تبدیل به معیار شوند زیرا استفاده اشتباه و احساسی از این ابزارها میتواند موجب آسیبهای جبرانناپذیر شود.